|

Size: 2970

Comment:

|

Size: 3950

Comment:

|

| Deletions are marked like this. | Additions are marked like this. |

| Line 4: | Line 4: |

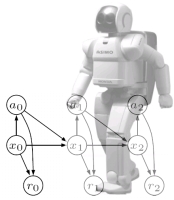

| ||<(^|2> '''Vorlesung:''' || Dienstag 14.00-16.00 || | ||<(^|2> '''Vorlesung:''' || Dienstag 14.00-16.00 ||<^|6> {{attachment:bn.png|Bayesian Planning|width=190}} || |

| Line 12: | Line 12: |

| Line 15: | Line 17: |

| auf gerichteten/ungerichteten Graphen und erlauben somit die explizite Modellierung von Variablen (=Knoten) und Korrelationen zwischen Variablen (=Kanten). |

auf gekoppelten Variablen. Die gerichtete oder ungerichtete Graphstruktur erlaubt somit eine sehr flexible Modellierung von Variablen (=Knoten) und Anhängigkeiten zwischen Variablen (=Kanten). |

| Line 19: | Line 21: |

| Zusammen mit einer mächtigen Inferenzmaschinerie (z.B. Viterbi Algorithmus, Junction Tree Algorithmus) erlauben graphische Modelle die direkte Modellierung von natürlich auftretenden Problemstellungen. Sie werden beispielsweise in der Handlungsplanung von Robotern, und der maschinellen Sprach- und Bildverarbeitung erfolgreich eingesetzt. Desweiteren basieren viele |

In den letzten Jahren wurden eine Reihe sehr mächtiger Inferenzalgorithmen (z.B. Viterbi Algorithmus, Junction Tree Algorithmus) entwickelt, die es uns erlauben graphische Modelle direkt für die Modellierung von natürlich auftretender Problemstellungen zu nutzen. Sie werden beispielsweise in der Handlungsplanung von Robotern und der maschinellen Sprach- und Bildverarbeitung erfolgreich eingesetzt. Desweiteren basieren viele |

| Line 27: | Line 30: |

| Die Vorlesung stellt graphische Modelle anhand von praktischen Beispielen aus den genannten Gebieten (Robotik, Sprach- und Bild- verarbeitung) vor. Thematisch beginnen wir mit einfachen Bayesschen |

Die Vorlesung führt in die Grundlagen Graphischer Modelle ein und stellt sie anhand von praktischen Beispielen aus den genannten Gebieten (Robotik, Sprach- und Bildverarbeitung) vor. Thematisch beginnen wir mit einfachen Bayesschen |

| Line 32: | Line 34: |

| her. Am Ende sollen die Teilnehmer in der Lage sein beliebige | her. Am Ende sollen die Teilnehmer in der Lage sein, beliebige |

| Line 39: | Line 41: |

| gute Mathematikkenntnisse; Statistikkenntnisse sind nützlich aber nicht zwingend erforderlich. | gute Mathematikkenntnisse; Statistikkenntnisse sind nützlich, aber nicht zwingend erforderlich. === Übungen === Es gibt jede Woche ein Übungsblatt. Voraussetzung zur Teilnahme an der Prüfung ist die erfolgreiche Bearbeitung der Hälfte aller Übungsaufgaben. Erfolgreiche Bearbeitung bedeutet, dass es ersichtlich wird, dass man sich mit der Aufgabe auseinandergesetzt hat und die zugrundeliegenden Themen prinzipiell verstanden hat. Blätter werden einzeln bearbeitet. Zu Beginn jeder Übung ist auf einer Liste anzukreuzen, welche Aufgaben man bearbeitet hat. Unter den möglichen Kandidaten wird einer per Zufall bestimmt, der die Aufgabe an der Tafel vorrechnet. Falls man an der Teilnahme der Übung verhindert ist, kann seine Bearbeitung in der Vorlesung abgeben. |

| Line 44: | Line 52: |

| || '''Datum''' || '''Beschreibung''' || || 21.04. || Einführung mit Überblick || |

|| '''Datum''' || '''Beschreibung''' || Vorlesung || Übung || || 21.04. || Einführung mit Überblick || [[attachment:01.pdf|vl01]] || [[attachment:ex1.pdf|ex1]] || |

| Line 50: | Line 58: |

| || 19.05. || Beliefpropagierung in zyklischen Graphen, Mean-Field Alg. || | || 19.05. || Beliefpropagierung in zyklischen Graphen (Loopy BP), Mean-Field Alg. || |

| Line 55: | Line 63: |

| || 16.06. || Strukturierte Support-Vektor-Maschinen (SSVMs) || | |

| Line 56: | Line 65: |

| || 16.06. || Strukturierte Support-Vector Maschinen (S-SVMs) || |

Describe Main/SS09_GraphicalModels here.

Vorlesung "Einführung in Graphische Modelle"

Vorlesung:

Dienstag 14.00-16.00

FR-6535

Übung:

Dienstag 16.00-18.00

FR-4061

Dozenten:

Tobias Lang (Übung)

Inhalt

Graphische Modelle definieren Warscheinlichkeitsfunktionen auf gekoppelten Variablen. Die gerichtete oder ungerichtete Graphstruktur erlaubt somit eine sehr flexible Modellierung von Variablen (=Knoten) und Anhängigkeiten zwischen Variablen (=Kanten).

In den letzten Jahren wurden eine Reihe sehr mächtiger Inferenzalgorithmen (z.B. Viterbi Algorithmus, Junction Tree Algorithmus) entwickelt, die es uns erlauben graphische Modelle direkt für die Modellierung von natürlich auftretender Problemstellungen zu nutzen. Sie werden beispielsweise in der Handlungsplanung von Robotern und der maschinellen Sprach- und Bildverarbeitung erfolgreich eingesetzt. Desweiteren basieren viele aktuelle Verfahren des maschinellen Lernens wie z.B. Hidden Markov Models (HMM), Conditional Random Fields (CRFs) oder Structured Support Vector Machines (SSVM) auf graphischen Modellen.

Die Vorlesung führt in die Grundlagen Graphischer Modelle ein und stellt sie anhand von praktischen Beispielen aus den genannten Gebieten (Robotik, Sprach- und Bildverarbeitung) vor. Thematisch beginnen wir mit einfachen Bayesschen Netzwerken, lernen dann verschiedene Inferenzmechanismen kennen und leiten schliesslich aktuelle Lernverfahren wie HMMs, CRFs und SSVMs her. Am Ende sollen die Teilnehmer in der Lage sein, beliebige Problemstellungen mit Hilfe von graphischen Modellen zu kodieren und zu lösen.

Voraussetzungen

gute Mathematikkenntnisse; Statistikkenntnisse sind nützlich, aber nicht zwingend erforderlich.

Übungen

Es gibt jede Woche ein Übungsblatt. Voraussetzung zur Teilnahme an der Prüfung ist die erfolgreiche Bearbeitung der Hälfte aller Übungsaufgaben. Erfolgreiche Bearbeitung bedeutet, dass es ersichtlich wird, dass man sich mit der Aufgabe auseinandergesetzt hat und die zugrundeliegenden Themen prinzipiell verstanden hat. Blätter werden einzeln bearbeitet. Zu Beginn jeder Übung ist auf einer Liste anzukreuzen, welche Aufgaben man bearbeitet hat. Unter den möglichen Kandidaten wird einer per Zufall bestimmt, der die Aufgabe an der Tafel vorrechnet. Falls man an der Teilnahme der Übung verhindert ist, kann seine Bearbeitung in der Vorlesung abgeben.

Termine

Datum

Beschreibung

Vorlesung

Übung

21.04.

Einführung mit Überblick

28.04.

Diskrete Wahrscheinlichkeitsverteilungen, Bedingte und Gesamtwahrscheinlichkeiten, Graphische Modelle, Faktorgraphen

05.05.

Inferenz, Eliminierungsalgorithmus, Evidenzen

12.05.

Summen-Produkt-Algorithmus, Junction Tree Alg. (JTA)

19.05.

Beliefpropagierung in zyklischen Graphen (Loopy BP), Mean-Field Alg.

26.05.

Hidden Markov Models (HMMs), Forward-Backward Alg., Viterbi, Expectation-Maximization (EM)

02.06.

Bedingte Wahrscheinlichkeiten, (Kernel-) Conditional Random Fields (k-CRFs), Features, Optimierung

09.06.

Optimierung (Fortsetzung), Strukturiertes Perzeptron

16.06.

Strukturierte Support-Vektor-Maschinen (SSVMs)

23.06.

Influence Diagramme

30.06.

Markov Decision Processes (MDPs)

07.07.

Inferenz für Planen, Optimale Handlungsanweisungen (Policies)

14.07.

Zusammenfassung und Fragestunde